LM Studio を使ってローカルでLLMを実行する方法 - Insight Edge Tech Blog

2025.03.10 13:09

Insightedge.jp

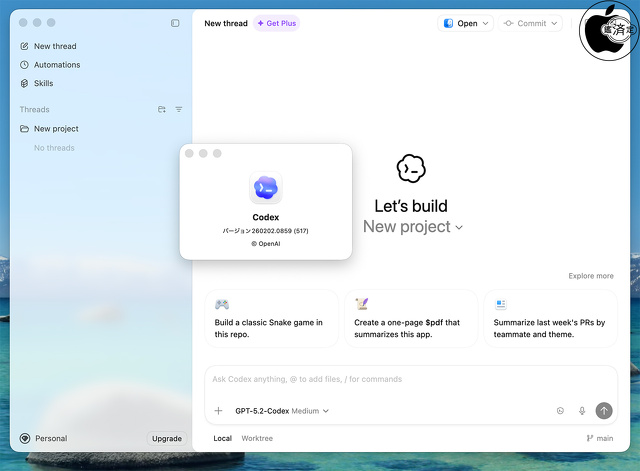

こんにちは、Insight Edgeでリードデータサイエンティストを務めているヒメネス(Jiménez)です!前回の投稿から丸1年経ちましたが、改めて皆さんと知識共有できればと思います。今回は、話題のOpen Source LLM(Llama, Mistral, DeepSeek等)をローカルで実行する方法を紹介します。 目次 LM Studioの紹介 LLMをローカルで実行 準備 Pythonプログラムから実行 単体実行 OpenAIを通した実行 活用例:討論する哲学者 哲学者の定義 討論内容の定義 討論の実施…

検索

人気記事

コメント一覧

まだコメントはありません。